Как проверить сайт на битые ссылки: лучшие сервисы для проверки

Содержание:

- Чем опасны битые ссылки?

- Как удалить битые ссылки с сайта WordPress?

- С помощью Yandex.Webmaster и Search Console

- Как найти битые ссылки на сайте онлайн бесплатно?

- Как найти битые ссылки

- Сервисы, работающие с битыми ссылками

- Как исправить или удалить битые ссылки

- Откуда появляются битые ссылки?

- Чем вредны битые ссылки на сайте

- Что такое «битая ссылка», чем они плохи и как появляются на сайте?

- Внешняя ссылочная масса

- Чем грозит наличие битых ссылок на сайте

- С помощью плагинов для WordPress

Чем опасны битые ссылки?

Есть две неподтвержденные теории и один солидный факт, подтверждающие серьезную угрозу со стороны битых ссылок.

Первая теория такая. Считается, что поисковые роботы Google и Яндекс не любят битые ссылки. Заприметив оные, поисковики решат, что сайт уже давно бросили или сделали так криво, что и стыдно его людям показывать. В связи с этим, позиции ресурса в Google и Яндекс заметно «просядут». Но никто еще не доказал, что это так.

Вторая теория. Якобы битые ссылки расходуют краулинговый бюджет — объем страниц, который поисковики сканируют за определенный период времени. Здесь вмешался представитель Google и сказал, что появление 404 ошибки никак не повлияет на краулинговый бюджет.

А вот что реально важно, так это отношение посетителей к сайту с битыми ссылками. На таких долго не задерживаются

Обычно 404 Not Found говорит о том, что надо бы перейти на главную страницу и воспользоваться поиском. Но всем плевать. Человек просто вернется в Google и будет искать ресурс с рабочими ссылками. Все. Вы потеряли своего посетителя.

Из-за этого вырастет доля отказов. А это не только упущенная аудитория, но и проблемы с ранжированием. Поисковик простит вам битую ссылку, но не простит визитер, который провел на сайте всего секунду и неожиданно убежал.

Как удалить битые ссылки с сайта WordPress?

Все ошибочные линки безусловно отрицательно сказываются на оптимизации продвижения ресурса. Реклама остается основным «инструментом» интернет-маркетинга, но она подразумевает не только текстовое наполнение, а также переход на внутренние и внешние ссылки, которые бывают поврежденными. Удалить битые ссылки с сайта WordPress достаточно просто. Нужно лишь установить необходимую систему BrokenLinkChecker, о которой упоминалось выше.

Плагин Broken Link Checker имеет ряд преимуществ, а потому пользоваться им одно удовольствие. Он системно начинает функционировать сразу после установки, сканирует выборочные элементы сайта с помощью заданной пользователем программы, имеет ряд инструментов, подстраивающихся под ситуацию, предоставляет возможность сразу устранять проблему битых ссылок и выполняет много других незаменимых функций.

После установки плагина необходимо перейти в раздел «Инструменты» далее «Неправильные ссылки» и программа тут же начнет поиск несуществующих источников. После окончания поиска, плагин покажет все битые ссылки, а пользователь уже сможет либо удалить их, либо отредактировать, сделав рабочими.

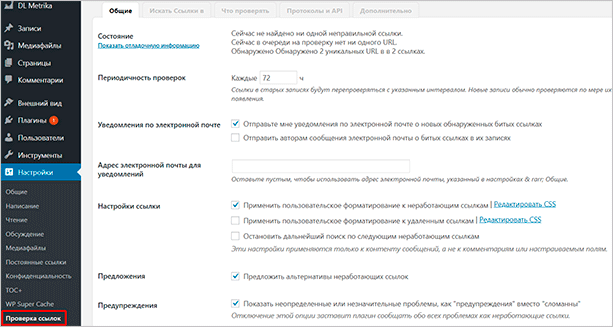

Функциональные настройки системы можно оставить стандартными, но хотелось бы упомянуть о возможных изменениях. Для этого необходимо зайти в раздел «Параметры» далее «Проверка ссылок»

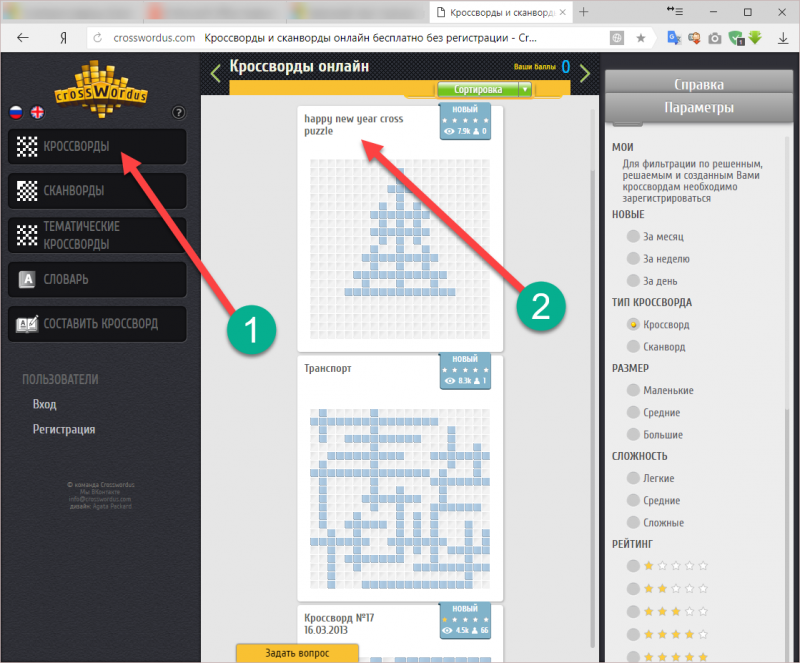

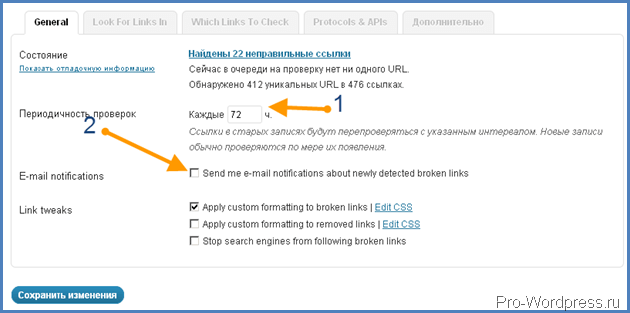

Цифра 1 указывает на окно, в котором можно выставить время с каким интервалом будет проводиться сканирование битых ссылок. Было бы целесообразней отключать плагин сразу после проверки, а в случае очередного сканирования снова активировать, но, если пользователь оставляет систему активной — данная настройка будет очень кстати.

Цифра 2 на рисунке выше представляет окошко, галочка в котором будет означать согласие в получении уведомлений на почту о появлении новых битых ссылок.

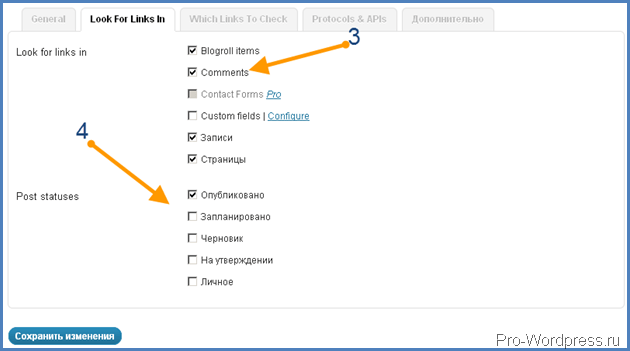

Цифра 3 представлена пунктами с окнами для указания пометок в каких разделах сайта необходимо проверять наличие битых ссылок.

Цифра 4 дает возможность установить статус проверяемых постов.

Это перечень основных настроек, которые помогут в удалении и исправлении битых ссылокна сайтах с движком WordPress.

Самое главное в работе над созданием любого проекта иметь представление о том, какой контент будет представлять сайт и, используя внешние и внутренние ссылки в разделах помнить, что битые ссылки негативно воспринимаются аудиторией и могут привести к уменьшению доверия, падению рейтинга и торможению правильного функционирования всего ресурса. Поэтому будет правильнее детально подойти к вопросу успешности Вашего проекта и доверить разработку знающим специалистам.

Надеемся, что наша статья поможет каждому пользователю понять, что такое битые ссылки, к каким проблемам могут привести и как с ними без труда справляться, применяя современные решения и качественные методы работы.

С помощью Yandex.Webmaster и Search Console

Если ваш ресурс добавлен в Яндекс Вебмастер и Консоль от Гугла (что нужно сделать обязательно), то вы можете без проблем найти все битые ссылки через них. Но не забывайте, что в отличие от онлайн-сервисов и плагинов, Yandex.Webmaster и Search Console умеют проверять только внутренние ссылки вашего сайта. То есть, если на странице будет битая внешняя ссылка, то эти инструменты ее проигнорируют.

Yandex.Webmaster

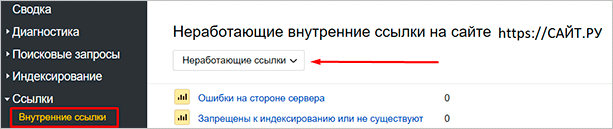

В Вебмастере от Яндекса вы должны перейти в раздел “Ссылки” – “Внутренние ссылки”. Там будут представлены все неработающие адреса, которые ведут на 404-ю ошибку.

Здесь будет представлена вся информация по битым адресам. Включая ошибки на стороне сервера, или те, которые вы создали самостоятельно. Например, при неправильной настройке robots.txt.

Search Console

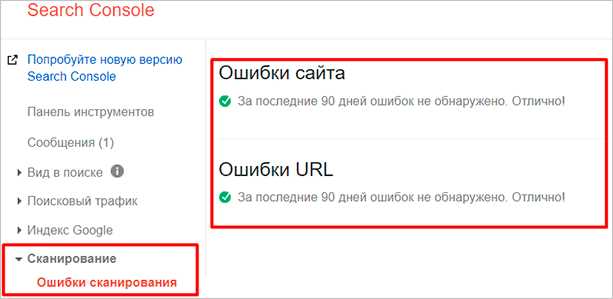

В консоли от Гугла вы точно также сможете увидеть неработающие адреса. Для этого вы должны перейти в раздел “Сканирование” – “Ошибки сканирования”. Там вы сможете увидеть все ошибки сканирования вашего ресурса, включая 404-ю.

Учтите, что в этом разделе будут представлены не только ссылки внутри вашего проекта. Тут будут и адреса с других сайтов, которые могли ошибиться при размещении какого-то материала.

В любом случае, если большое количество трафика идет по какому-то неработающему адресу, то целесообразнее будет сделать редирект на верную статью. Так вы сделаете жизнь многих пользователей легче и в то же время не потеряете львиную долю трафика.

Поиск неработающих адресов через инструменты от поисковиков, по моему мнению, является наиболее приоритетным вариантом. Так вам не придется устанавливать дополнительные плагины или обращаться к сторонним онлайн-сервисам, не все из которых, кстати говоря, бесплатные.

Но вот что касается исправления ошибок, то тут уже придется поработать. Как я и говорил в начале этой статьи, найти битые адреса не проблема. Проблема – грамотно исправить эту ошибку, сохраняя желание пользователей просматривать страницы вашего ресурса.

Вручную настроить переадресацию не всегда получится. Битых линков может быть за сотню, и если для каждого, подчеркиваю, отдельно делать редирект – можно с ума сойти.

Можно, конечно, заставить делать эту монотонную работу какого-нибудь фрилансера, но зачем переплачивать, когда есть более быстрый и, что самое главное, бесплатный способ?

Как найти битые ссылки на сайте онлайн бесплатно?

Самый доступный способ, это заходить на каждую страницу и проверять. Хорошо если у вас всего несколько страниц, а если сотни и тысячи. Такой вариант отпадает сразу. Тогда, лучше использовать онлайн сервисы для поиска неработающих ссылок. Ниже покажу как:

С помощью Яндекс вебмастера

Заходим в панель управления – ссылки – внутренние ссылки.

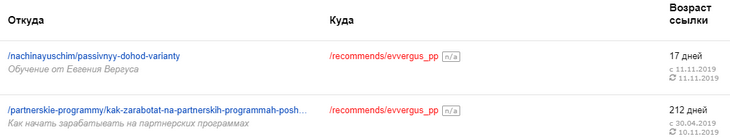

Пролистываем страницу вниз и под графиком видим все не работающие ссылки.

Откуда: это адрес вашей страницы, под адресом серым цветом выделен анкор(слова в которые вставлена ссылка).

Куда (красная ссылка): куда ведет – рубрика, другой сайт, статья.

На моем примере вебмастер показывает, даже измененные рубрики. Я изменил название рубрики, соответственно и изменился ее адрес.

С помощью консоли Гугл

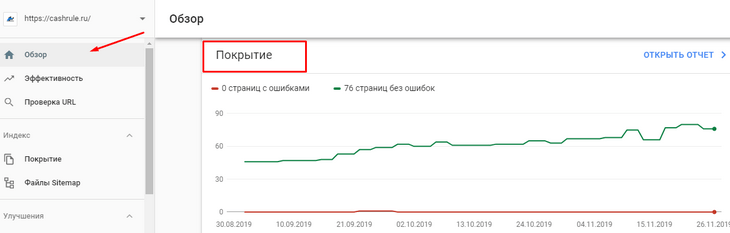

Заходим в Google Search console, выбираем обзор. Смотрим окно «покрытие».

Как вы видите, гугл не видит ошибок на страницах.

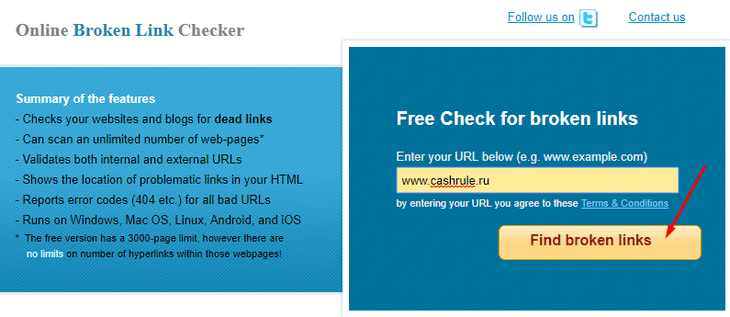

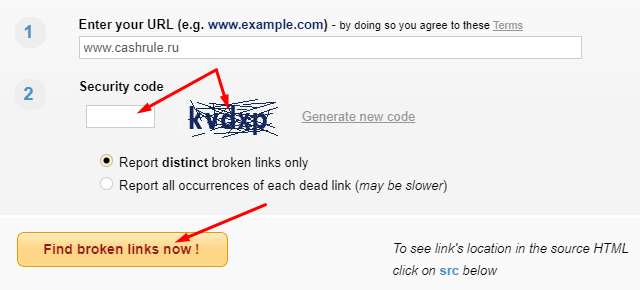

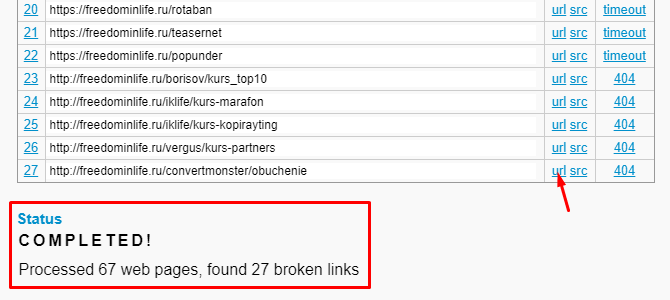

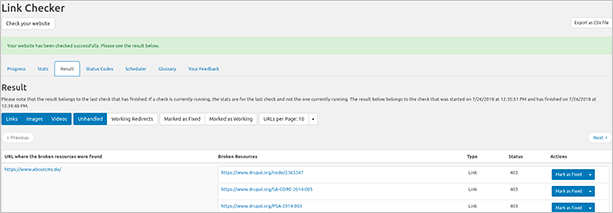

Онлайн сервис brokenlinkcheck

Я знаю, какие линки у меня не рабочие и поэтому решил проверить несколько сервисов сразу. Из штук 7-ми — 10-ти только один нашел действительно неработающие – это brokenlinkcheck.com. Остальные не понятно что ищут. Вернее они ищут, но не видят битые исходящие ссылки, как в моем случае.

- В поле «Enter your URL below» вводим ваш адрес сайта и жмем «Find broken links«.

- На следующей странице, вводим капчу и снова жмем «Find broken links now!«

- Ждем, пока закончится процесс поиска.

- В таблице, во второй колонке кликаем на url и вас перебросит на ту страницу, где находиться нерабочая ссылка. Находим и исправляем ее.

Подводя итог по онлайн сервисам хочется отметить, что лучше всего проверить сайт в нескольких сервисах – это увеличит вероятность обнаружения. Еще лучше будет, если вы будете знать хотя бы об одной битой ссылке на своем блоге. Так вы сразу сможете определить достоин сервис внимания или нет.

Как найти битые ссылки

Это можно сделать с помощью панели Вебмастера Яндекса, плагина для Вордпресс или специальных программ и онлайн-сервисов. Давайте к рабочим способам. С их помощью можно найти битые ссылки, все до единой.

Ищем битые ссылки с помощью онлайн-сервисов

Удобство таких сервисов в том, что ничего не нужно скачивать или устанавливать. Открыл программку прямо в браузере, проверил и получил результат. Онлайн-сервисы бывают как платные, так и бесплатные.

Broken Link Checker

Это плагин для WordPress. BrokenLink Checker помимо обычной проверки на внешние и внутренние битые линки, еще и точно указывает их место в коде.

Вот довольно полная видео инструкция от автора блога Azoogle:

Если ваш сайт сделан на WordPress, скачиваем плагин, активируем его и настраиваем:

- Заходим в админку Вордпресс, жмем Параметры – Проверка ссылок;

- Где периодичность проверок, можно выставить значение «72» (каждые 72 часа), или свое число;

- Во вкладке Look For Linksin оставляем галочки на записях и страницах, в комментариях нам искать битые ссылки не обязательно, поэтому отметку можно убрать;

- Оставшиеся настройки изменять не нужно. Нажимаем «сохранить изменения».

После окончания проверки показывается, сколько неправильных ссылок обнаружил плагин. При нажатии на это число, можно увидеть каждый найденный адрес, в котором присутствует ошибка. Каждую ссылку есть возможность даже исправить вручную, открыв в «Источнике» эту самую запись. Также откорректировать гиперссылку можно и в окне плагина, путем изменения (редактирования) URL на правильный, либо эту ссылку можно и вовсе удалить.

Яндекс Вебмастер

Определить, есть ли на вашем ресурсе несуществующие страницы, поможет и старый добрый Яндекс Вебмастер. В меню слева нужно выбрать пункт «исключенные страницы» и вам откроется информация о всех проблемных страницах, которые не получилось проиндексировать

Ошибка 403 или 404 указывает на наличие несуществующих адресов, в первую очередь, обратите внимание именно на эти ошибки. Также в вебмастере есть возможность выгрузки в Excel — удобно, особенно если ошибок выявилось очень много

https://youtube.com/watch?v=xePymYgS1q4

Google Вебмастер

Также как и в Яндексе, в Гугл тоже есть возможность проверить свой ресурс на наличие несуществующих страниц. В панели вебмастера откройте вкладку «Ошибки сканирования» в разделе «Диагностика». Так вы увидите, с каких страниц, и какие ссылки не обнаружены. Если нажать на число возле записи, то вам откроется информация о страницах, содержащих битые линки.

Парсеры

Отличаются от онлайн-сервисов тем, что требуют установки на комп. Минус таких программ в том, что загрузочный файл может быть заражен вредоносным ПО. Прежде чем устанавливать программу, просканируйте её на наличие вирусов. Итак, какие программы для поиска битых линков считаются самыми востребованными? Давайте посмотрим.

Xenu Link Sleuth

Олдовый вариант. Сеошники впитали его вместе с молоком матери. Как пользоваться этой программой? Устанавливаем её к себе на компьютер, открываем, в меню выбираем File – Check URL, после чего нужно ввести адрес сайта, который хотите проанализировать. Около check external links отметку убираем и нажимаем ОК. При первичном запуске парсера, проверка сайта осуществляется намного дольше. Отличие этой программы от проверки поисковиками состоит в том, что она гарантирует актуальность всех данных, анализируя веб-ресурс в режиме реального времени. Единственный ее минус – это небольшая скорость проверки, особенно долго проверяются ресурсы, в которых тысячи страниц.

PageWeight

Еще одна неплохая программа для парсинга страниц и всех ссылок сайта. Фиксирует все кривые ссылки и указывает проблему каждой. Есть возможность настроить различные варианты сканирования, рассчитать статический вес страницы ресурса. Функция «моделирование» в PageWeight позволяет изменять варианты перелинковки, с ее помощью можно как удалить, так и добавить ссылку. Единственный минус – программа платная, у бесплатной версии сильно урезан функционал, поэтому лучше не пожалеть денег и купить полную версию. С пейдж вейт можно сделать правильную внутреннюю перелинковку и убрать битые линки, забирающие вес ресурса.

Screaming Frog

Программа по функциям в общем-то похожа на PageWeight. Может находить дубли страниц и кривые URLы. В отличие от других парсеров, есть версия под Mac.

Сервисы, работающие с битыми ссылками

В то время, как плагины помогают выявлять и исправлять битые ссылки, сервисы проверки помогают только находить такие ссылки. Это всё-таки лучше, чем ничего, верно? Единственный недостаток – вам придётся исправлять неработающие ссылки вручную или с помощью плагинов.

Услуги посторонних сервисов включают в себя:

- W3C Link Checker – эта проверка показывает все мёртвые ссылки, код их статуса (например, 404, 403, 301 и т. д.) и рекомендуемый порядок действий.

- Google Webmaster Tools – это отличный инструмент, позволяющий проверить не только битые ссылки, но и другие ошибки сайта. Он предоставит вам много информации о ваших ссылках, может классифицировать ошибки и предложить вам различные подробности, например, когда битые ссылки были впервые обнаружены.

- Online Broken Link Check – это базовый онлайн-инструмент, который пригодится, если вам нужно отсканировать большой сайт. Это занимает время, а бесплатная версия позволяет вам просканировать до 3000 страниц. Кроме того, вам придётся приобрести платную версию, чтобы проверять ссылки на документы (pdf, doc, xls и т. д.) и изображения, что может явиться некоторым разочарованием.

Как исправить или удалить битые ссылки

Не всегда есть необходимость удалять некорректно работающий линк. Вполне возможно, что ресурс, на который вы ссылаетесь, изменил структуру. В таком случае следует отыскать новый адрес со старым контентом, скопировать новую ссылку и исправить у себя на сайте. Это актуально по отношению к внешним ссылкам.

Если вы добавили новый раздел или удалили старый, вложили старый раздел в новый, переместили статью в другую категорию, не забудьте сделать перенаправление или удалить старые URL посредством файла robots.txt и панелей вебмастеров. Это актуально по отношению к внутренним ссылкам.

Итог

Битые ссылки — это не смертельно. Однако чтобы повысить траст сайта, необходимо проводить внутреннюю оптимизацию в комплексе. Чтобы вывести ресурс в ТОП поисковой выдачи, важна каждая мелочь и «мертвые» ссылки в этой цепочке играют не последнюю роль.

Откуда появляются битые ссылки?

Чтобы разобраться с ошибками «error 404 (Not found)», необходимо узнать, почему они возникают. Итак, факторы, влияющие на появление такой проблемы, как битые ссылки, следующие:

- неправильное функционирование сервера;

- на сайте произведено удаление информации;

- перемены или опечатки в URL.

Узнаем о них более детально.

Чтобы устранить битые ссылки, необходимо в обязательном порядке проводить рейды по их поиску. На порталах возможны любые трансформации, включая полное удаление какой-либо страницы. Если же ссылка вела на одну из них, то система выдаст ошибку, о которой мы говорили выше.

О существовании временных страниц на сайтах знают многие, информация устаревает очень быстро. Об этом стоит помнить и актуализировать ссылки на данные источники. Бывают ситуации, когда порталы вообще перестают функционировать. Это может произойти или по причине ликвидации компании, либо хозяин забыл вовремя оплатить счет за домен

В итоге проект перестал работать автоматически.

Важно! Если появилась необходимость удалить страницу на веб-ресурсе, то обязательно пропишите «301 редирект» на странице, от которой избавились. Нужно это для перенаправления посетителей по актуальному адресу.

Изменения в структуре сайта

Дополняя ресурс новой информацией, администраторы чаще всего подтягивают веб-страницы, которые уже были на нём. Процесс связывания страниц одного сайта (перелинковка) также может создать неработающие гиперссылки. Частая проверка всего содержания ресурса исключит появление такого отклонения, как битые линки.

Рассмотрим пример.

URL такого вида, как site.ru/ingushki/tovar10/ содержал соответствующие изделия в разделе «Игрушки», потом его перенесли в «Игрушки для девочек» с присвоением URL — site.ru/ingushki-dlya-devochek/tovar10/. Мы видим, что в этой ситуации первый адрес перестал существовать, переход по нему выдаст пользователю ошибку.

Погрешности в работе сотрудников по программированию, контент-менеджеров, веб-мастеров. Это элементарный человеческий фактор. Сотрудники, которые трудятся над веб-сайтами, могут ошибиться всего лишь в одном символе, и ссылка уже не будет работать. Здесь важно проверять за собой функционирование каждого линка в отдельности.

Чем вредны битые ссылки на сайте

Такие ссылки участвуют во внутренней перелинковке и нарушают распределение ссылочного веса, перетягивая на себя часть авторитетности донора.

Битым ссылкам часто приписывают лишний негатив. В статьях про краулинг встречается информация, что битые ссылки отрицательно влияют на краулинговый бюджет — ресурсы, которые ПС выделяет на сканирование сайта. Пишут, что краулер потратит лимиты на бесполезный обход битых ссылок и из-за этого проигнорирует важные страницы.

По словам Джона Мюллера, сотрудника Google, это не так: 4хх ошибки не приводят к снижению краулингового бюджета. Бот повторно сканирует эти страницы, чтобы убедиться, что они закрыты, но делает это не в ущерб остальным страницам.

Еще Джон Мюллер отмечает, что неважно, сколько страниц с ошибками 404 есть на сайте, фактом своего наличия они не могут снизить рейтинг остальных страниц. Но это касается не всех страниц 4хх

В блоге Google перечисляют страницы, которые негативно влияют на распределение бюджета, и среди них есть «мягкие страницы ошибок», то есть 404 SOFT

Но это касается не всех страниц 4хх. В блоге Google перечисляют страницы, которые негативно влияют на распределение бюджета, и среди них есть «мягкие страницы ошибок», то есть 404 SOFT.

404 SOFT возникают, если для несуществующей страницы сервер должен ответить кодом 404 или 410, а вместо этого отвечает HTTP-кодом ответа 200 OK. В таком случае краулер воспринимает страницу как обычно, сканирует ее и тратит краулинговый бюджет вместо обхода действительно важных страниц.

Большое количество страниц 404 точно не принесет никакого положительно эффекта, а навредить может, поэтому лучше их исправить. Найти страницы 404 помогут специальные сервисы и инструменты.

Что такое «битая ссылка», чем они плохи и как появляются на сайте?

Битая ссылка — такая ссылка, при переходе по которой сервер отдает ответ «страница не существует или не найдена».

Ссылка, документ или изображение запрашиваемые пользователем могут действительно не существовать, а могут «потеряться» из-за неправильной работы/настройки сервера или сайта.

Задача вебмастера и владельца сайта — чтобы ссылок на несуществующие страницы, документы и фалы на сайте не было. Т.е. пользователь, при клике на любую ссылку, гарантированно должен перейти на следующую страницу и увидеть там ожидаемое содержимое.

Битые ссылки очень плохо сказываются на отношении пользователей к сайту. Человек пришел за информацией на ваш сайт, увидел ссылку по теме, чтобы узнать еще больше информации… Переходит по ней, а там ничего нет.

Нельзя забывать и о поисковиках. Представьте — поисковый робот ходит по вашему сайту и регулярно натыкается на битые ссылки. Какой вывод должна сделать поисковая система в этом случае?

Что вы не обновляете контент, не следите за актуальностью информации и ссылаетесь вообще не понятно куда. Соответственно, ПС может и понизить сайт в выдаче из-за этого, если битых ссылок большое количество.

Самое плохое в битых ссылках это то, что они незаметные. У редкого владельца сайта есть полноценная аналитика — по каким ссылкам и на каких страницах кликают пользователи. Сами же вебмастера по своим ссылкам чаще всего не ходят — написали запись, опубликовали, забыли. Проходит год-два, вебмастер уже и забыл о этих ссылках, а часть из них превратилась в битые.

Пользователи приходят на сайт по запросам и хотят дальше серфить по интернету, а не получается — ссылки-то не рабочие. И вебмастер об этом чаще всего не знает. Непорядок.

Интернет это очень динамичная система с самого своего зарождения. И чем дальше — тем динамичнее.

Количество проиндексированных поисковыми системами страниц растет каждый день, создаются тысячи новых сайтов, сотни прекращают свое существование. Ну а работающие сайты периодически меняют ЧПУ, содержание, добавляют новые страницы и файлы, удаляют старые.

Если на вашем 20 страниц и битые ссылки легко контролировать, то на чужом сайте может быть 10000 страниц и их контролировать невозможно. Особенное если вы ссылаетесь на веб-документы на нескольких чужих сайтах — не можете же вы постоянно отслеживать доступность всех ссылок с сайта.

Как именно битые ссылки появляются на сайтах в интернете?

В каких случаях они появляются:

Есть еще несколько причин появления битых ссылок, но я выделил основные и пожалуй остановлюсь на этом.

Самое главное что должен понимать вебмастер, блоггер и оптимизатор: появление битых ссылок — естественный, необратимый процесс. Чем крупнее ваш сайт, чем чаще вы ссылаетесь на свои или чужие страницы — тем выше вероятность появления битых, неработающих ссылок на сайте.

Бороться с этим сложно (особенно на других сайтах) — поэтому я рекомендую периодически отслеживать их наличие на сайте. Это эффективнее.

Внешняя ссылочная масса

Что из себя представляет ссылочная база сайта? Это общее количество внешних ссылок, ссылающихся на один веб-сайт. Для поисковой системы не имеет значения, как и где установлена ссылка, в тексте, на картинке, написан url полностью, или на него идет переход с фразы (анкора), она учитывает все упоминания самого домена.

Раньше для попадания в топ было достаточно купить большое количество внешних ссылок и сайт автоматически получал рост позиций в выдаче. По сути, все поисковое продвижение состояло из поиска доноров и размещения на них ссылок. На качество самих площадок никто внимания не обращал, пока поисковые системы не начали борьбу с низкотрастовыми и спамовыми ссылками. Оптимизаторы продолжали массово закупать внешние ссылки, раздувая ссылочную массу до десятков тысяч урлов, пока Яндекс не ввел алгоритм под названием «Минусинск». После апдейта выдачи, более 70% сайтов вылетели с первых страниц. Google не остался в стороне и запустил похожий алгоритм под названием «Пингвин», заставив вебмастеров и оптимизаторов кардинально пересмотреть стратегию продвижения, а многим владельцам сайтов пришлось выводить свои ресурсы из под фильтров поисковых систем.

Классификация ссылок

Внешняя ссылочная масса сайта делится на различные виды ссылок, каждая из которых имеет своё значение. Веб-сайт имеющий только один вид урл вызовет у поисковой системы столько же подозрений, сколько сайт с некачественной ссылочной массой. Выделим основные пять видов:

-

Технические ссылки. Как это правило сайты с информацией о домене. Появляются подобные ссылки автоматически, влияния на выдачу они не имеют.

-

Ссылки со справочников. Тематические каталоги, порталы желтых страниц, сайты-справочники. Данный вид ссылок является наиболее естественным, при условии, что добавление происходит не в автоматическом режиме и на тематический сайт.

-

Социальные ссылки. Неиндексируемые ссылки из сообщений или профилей социальных сетей Vkontakte, Instagram, Facebook, Twitter, LinkedIn. На рост позиций влияние не оказывают, но на цитирование сайта и разнообразие ссылочного профиля влияют.

-

Крауд-ссылки. Профили сайтов, подписи на форумах, карточки компаний, где можно указать домен. Крауд считается хорошим типом ссылок, однако поставить ссылку на посещаемом форуме очень сложная задача. Либо все url закрываются от индексации, либо модератор сразу удаляет профиль/сообщение.

- Вечные ссылки. Гиперссылка, размещенная в тексте и существующая пока доступен сам домен. Именно такого рода ссылки покупаются оптимизаторами и вычисляются поисковыми системами.

Какими должны быть ссылки на сайт

Не количество ссылок играет ключевую роль в продвижении, а их качество. Анализируя ссылочный профиль, или выбирая донора для размещения своих урл, нужно учитывать следующие показатели:

-

Регион сайта-донора и вашего веб-сайта должен быть единым. Согласитесь, увидеть на русском сайте анкорную ссылку на другом языке будет странно даже для пользователя. Аналогичным образом думают и поисковики.

-

Ссылочная база ресурса должна быть разнообразной и содержать все типы ссылок. Это позволит и получить рост позиций в выдаче, и обезопасить себя от санкций поисковых систем.

-

Домен на котором размещается ссылка не должен иметь большого количества других внешних ссылок и содержать запрещенные материалы. Показатель качества сайта ИКС и показатель уровня доверяю (траста) должны быть высокими.

-

С одного домена не должно идти более 3 ссылок на ваш веб-сайт, в противном случае поисковик можно посчитать это спам-ссылками, не беря в расчет показатели самого сайта.

Чем грозит наличие битых ссылок на сайте

Все мы стараемся максимально качественно и полно провести оптимизацию подопечных ресурсов. Это и понятно, ведь чем меньше проблем, тем качественнее сайт будет выглядеть в глазах поисковых систем. Даже небольшое число битых ссылок может сыграть злую шутку с владельцем ресурса. Робот может посчитать, что владелец не следит за ресурсом, не проводится модерация и т.д., что в свою очередь чревато наложением определённых санкций.

Если же говорить о живых посетителях, то они навряд ли будут довольны контентом с битой ссылкой

Особенно, если эта ссылка на скачивание, более развернутое описание материала, изображение с важной информацией и др. Именно по этой причине и поисковые системы так негативно относятся к битым ссылкам

Ведь главная задача для них — предоставить конечному пользователю наиболее качественный ответ на вопрос.

С помощью плагинов для WordPress

Самая популярная блоговая CMS давно уже имеет инструменты для борьбы с битыми адресами. Обычно, если какой-то адрес схож с другим, то ВП может автоматически перекидывать с 404-й страницы на реальную статью. Но это возможно не всегда.

Однако у нас всегда есть плагины. Тысячи различных вариантов, с помощью которых мы можем исправить ошибку 404 раз и навсегда. Плагины могут решать проблему по-разному.

Можно пойти по более легкому и быстрому пути – сделать переадресацию со всех битых адресов на главную. В этом случае поисковые системы не будут считать неработающие адреса за таковые, потому что будет редирект. Многие сеошники так и поступают, потому как поисковые системы хорошо реагируют на такие решения.

Есть и другой способ. Он заключается в настройке редиректов на конкретные материалы или страницы. То есть если человек переходит по какой-то старой ссылке, желая найти определенный пост, то вебмастер специально учитывает это и перебрасывает его в нужное место.

Некоторые плагины значительно облегчают эту задачу. Их мы и рассмотрим далее.

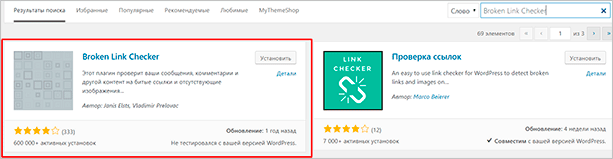

Broken Link Checker

Достаточно популярное решение, которое, к сожалению, не обновлялось уже больше года. Тем не менее плагин все еще работает, причем отлично. Для его установки вы должны перейти в “Плагины” – “Добавить новый”, после чего ввести в поле поиска название – Broken Link Checker.

Для установки просто кликните на одноименную кнопку, после чего не забудьте активировать модуль.

После успешной активации вы должны перейти в настройки расширения. Они доступны по пути “Настройки” – “Проверка ссылок”. Broken Link Checker поддерживает русский язык, поэтому даже у новичков он не вызовет трудностей при использовании.

Настройка Broken Link Checker не вызовет у вас затруднений. Несколько параметров, в которых разберется даже ребенок.

Link Checker

Новый плагин, который также позволяет искать неработающие адреса. Он часто обновляется, да и интерфейс там достаточно удобный. Все ошибки представлены в виде удобной страницы. При желании их можно легко исправить в один клик, настроив переадресацию на главную или любую другую страницу.

Yoast SEO Premium

В премиум-версии самого популярного плагина для WordPress – Yoast SEO также есть инструменты для проверки ресурса на битые ссылки. Расширение, как вы могли догадаться, платное. Стоимость – около 79 евро.

Помимо простого поиска Yoast позволяет удалить или переадресовать неработающий адрес. Премиум-вариант подойдет далеко не всем, но если вы из тех вебмастеров, которые вкладываются по максимуму, то Yoast SEO Premium – хороший выбор.

Тем более что у плагина есть куча других полезных функций, которые помогут оптимизировать ваш сайт для поисковых систем.

WP Broken Link Status Checker

Завершает нашу подборку WP Broken Link Status Checker. Стоит сказать, что он не обновлялся на протяжении последних двух лет. Однако плагин до сих пор остается актуальным и рабочим. Многие вебмастера пользуются продуктом с большим удовольствием и даже покупают про-версию.

Как и в предыдущих случаях, WP Broken Link Status Checker может найти битые внутренние ссылки, неработающие картинки и прочие ошибки, которые могут быть связаны с этим. Здесь же вы сможете быстро исправить все это. Либо вручную, либо с помощью переадресации. Также можно просто удалять ненужные адреса в один клик, используя интерфейс плагина.