Как заблокировать сайт на компьютере с windows или macos

Содержание:

- Контент

- Как полностью закрыть сайт на WordPress от индексации

- Примеры файлов robots.txt

- Закрываем от индексации поисковиков

- Установка плагина WP Maintenance Mode

- Использование спецсимволов в командах robots.txt

- Блокировка индексации сайта robots.txt

- Зачем это нужно

- Внутренние ссылки

- Ошибки, связанные с файлом robots.txt

- Пример настройки файла robots.txt

- Как заблокировать сайт в файле hosts, чтобы он не открывался

- Что такое индексация

- Как закрыть сайт от индексации в WordPress?

Контент

Проблемы, связанные с закрытием контента на сайте:

Страница оценивается поисковыми роботами комплексно, а не только по текстовым показателям. Увлекаясь закрытием различных блоков, часто удаляется и важная для оценки полезности и ранжирования информация.

Приведём пример наиболее частых ошибок:

– прячется шапка сайта. В ней обычно размещается контактная информация, ссылки. Если шапка сайта закрыта, поисковики могут не узнать, что вы позаботились о посетителях и поместили важную информацию на видном месте;

Зачем на сайте закрывают часть контента?

Обычно есть несколько целей:

– сделать на странице акцент на основной контент, убрав из индекса вспомогательную информацию, служебные блоки, меню;

– сделать страницу более уникальной, полезной, убрав дублирующиеся на сайте блоки;

– убрать «лишний» текст, повысить текстовую релевантность страницы.

Всего этого можно достичь без того, чтобы прятать часть контента!У вас очень большое меню?

Выводите на страницах только те пункты, которые непосредственно относятся к разделу.

Много возможностей выбора в фильтрах?

Выводите в основном коде только популярные. Подгружайте остальные варианты, только если пользователь нажмёт кнопку «показать всё». Да, здесь используются скрипты, но никакого обмана нет – скрипт срабатывает по требованию пользователя. Найти все пункты поисковик сможет, но при оценке они не получат такое же значение, как основной контент страницы.

На странице большой блок с новостями?

Сократите их количество, выводите только заголовки или просто уберите блок новостей, если пользователи редко переходят по ссылкам в нём или на странице мало основного контента.

Поисковые роботы хоть и далеки от идеала, но постоянно совершенствуются. Уже сейчас Google показывает скрытие скриптов от индексирования как ошибку в панели Google Search Console (вкладка «Заблокированные ресурсы»). Не показывать часть контента роботам действительно может быть полезным, но это не метод оптимизации, а, скорее, временные «костыли», которые стоит использовать только при крайней необходимости.

Мы рекомендуем:

– относиться к скрытию контента, как к «костылю», и прибегать к нему только в крайних ситуациях, стремясь доработать саму страницу;

– удаляя со страницы часть контента, ориентироваться не только на текстовые показатели, но и оценивать удобство и информацию, влияющую на коммерческие факторы ранжирования;

– перед тем как прятать контент, проводить эксперимент на нескольких тестовых страницах. Поисковые боты умеют разбирать страницы и ваши опасения о снижение релевантности могут оказаться напрасными.

Давайте рассмотрим, какие методы используются, чтобы спрятать контент:

Тег noindex

У этого метода есть несколько недостатков. Прежде всего этот тег учитывает только Яндекс, поэтому для скрытия текста от Google он бесполезен

Помимо этого, важно понимать, что тег запрещает индексировать и показывать в поисковой выдаче только текст. На остальной контент, например, ссылки, он не распространяется

Это видно из самого .

Поддержка Яндекса не особо распространяется о том, как работает noindex. Чуть больше информации есть в одном из обсуждений в официальном блоге.

Вопрос пользователя:

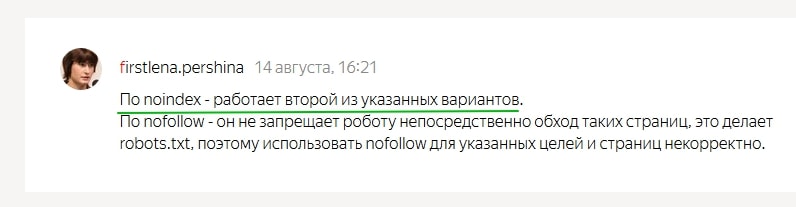

Ответ:

В каких случаях может быть полезен тег:

– если есть подозрения, что страница понижена в выдаче Яндекса из-за переоптимизации, но при этом занимает ТОПовые позиции по важным фразам в Google. Нужно понимать, что это быстрое и временное решение. Если весь сайт попал под «Баден-Баден», noindex, как неоднократно подтверждали представители Яндекса, не поможет;

– чтобы скрыть общую служебную информацию, которую вы из-за корпоративных ли юридических нормативов должны указывать на странице;

– для корректировки сниппетов в Яндексе, если в них попадает нежелательный контент.

Скрытие контента с помощью AJAX

Это универсальный метод. Он позволяет спрятать контент и от Яндекса, и от Google. Если хотите почистить страницу от размывающего релевантность контента, лучше использовать именно его. Представители ПС такой метод, конечно, не приветствую и рекомендуют, чтобы поисковые роботы видели тот же контент, что и пользователи.

Технология использования AJAX широко распространена и если не заниматься явным клоакингом, санкции за её использование не грозят. Недостаток метода – вам всё-таки придётся закрывать доступ к скриптам, хотя и Яндекс и Google этого не рекомендуют делать.

Как полностью закрыть сайт на WordPress от индексации

Способ 1. Через встроенную функцию в WordPress

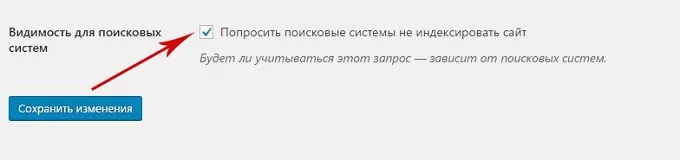

Удаление ресурса из поисковиков – процесс несложный. Осуществляется он с помощью встроенной функции в WordPress «закрыть сайт от индексации» и сканирования. Для этого:

- На панели управления администратора зайдите в Настройки, выберите Чтение.

- Найдите опцию «Видимость для поисковых систем». Поставьте галочку напротив «Попросить поисковые системы не индексировать сайт». Когда опция включится, файл txt подвергнется редактированию в соответствии с новыми правилами.

- Нажмите «Сохранить изменения», чтобы они вступили в силу.

Способ 2. Закрыть сайт от индексации через robots.txt

Если вам больше по душе делать все вручную, то можно самим заняться редактированием данного файла. Результат будет аналогичен. С помощью файла Роботс закрыть сайт от индексации нетрудно:

- Для доступа к файлам вашего сайта используйте Файловый менеджер или FTP-клиент.

- Найдите файл txt. Его местонахождение – папка, где расположен и WordPress (как правило, public_html). Если найти файл не получается, можно создать пустой.

- Закрыть сайт от индексации поисковиков можно, введя следующий синтаксис:

User-agent: *

Disallow: /

Первый код позволяет предотвратить как сканирование, так и индексацию вашего ресурса. Этот код в файле robots.txt – сигнал для поисковиков о том, что сканировать сайт запрещено.

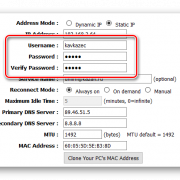

Способ 3. Защита сайта паролем с помощью контрольной панели вашего хостинга

Поисковикам и поисковым роботам доступ к файлам, которые защищены паролем, закрыт. Существуют следующие способы защиты файлов паролем:

Если вы – клиент Hostinger, то для включения функции защиты паролем вам нужно использовать инструмент, который называется «Защита Папок Паролем».

- Войдите в контрольную панель Hostinger и нажмите иконку Защита Папок Паролем.

- Слева отобразятся каталоги. Укажите те, которые нуждаются в защите. В нашем случае WordPress установлен в

- Выбрав каталог, введите имя пользователя и пароль в панели справа, нажмите «Защитить».

Процесс будет аналогичным и в случае использования cPanel. Потребуется:

- Войти в учетную запись cPanel и нажать Конфиденциальность каталога.

- Выбрать папку установки WordPress. Как правило, это

- Выбрать опцию «Защитить этот каталог паролем». После нужно ввести имя каталога и нажать «Сохранить». С помощью формы создать учетную запись пользователя для доступа к защищенным каталогам. После нажать «Сохранить».

Способ 4. Запаролить сайт, используя плагин

Получить аналогичный результат можно, установив плагины. Есть много плагинов, которые можно использовать в таких целях. Стоит выделить следующие: Password Protected Plugin, WordFence. Ваша задача – выбрать наиболее свежий и установить его.

После установки нужно будет зайти в настройки плагина и установить пароль для сайта. После того как вы защитите ваш ресурс паролем, доступ поисковикам к нему закроется. Соответственно, индексация ими сайта станет невозможной.

Вас также может заинтересовать: Инструменты аналитики сайта

Примеры файлов robots.txt

Пример (комментарий находится на отдельной строке):

Disallow: /cgi-bin/#комментарий

Пример файла robots.txt, разрешающего всем роботам индексирование всего сайта:

User-agent: *

Disallow:

Host: www.site.ru

Пример файла robots.txt, запрещающего всем роботам индексирование сайта:

User-agent: *

Disallow: /

Host: www.site.ru

Пример файла robots.txt, запрещающего всем роботам индексирование директории «abc», а так же всех директорий и файлов, начинающихся с символов «abc».

User-agent: *

Disallow: /abc

Host: www.site.ru

Пример файла robots.txt, запрещающего индексирование страницы «page.htm», находящейся в корневом каталоге сайта, поисковым роботом «googlebot»:

User-agent: googlebot

Disallow: /page.htm

Host: www.site.ru

Пример файла robots.txt, запрещающего индексирование:

– роботу «googlebot» – страницы «page1.htm», находящейся в директории «directory»;

– роботу «Yandex» – все директории и страницы, начинающиеся символами «dir» (/dir/, /direct/, dir.htm, direction.htm, и т. д.) и находящиеся в корневом каталоге сайта.

User-agent: googlebot

Disallow: /directory/page1.htm

User-agent: Yandex

Disallow: /dir

Host: www.site.ru

Закрываем от индексации поисковиков

Перед тем как рассказать о способе с применением robots.txt, мы покажем, как на WordPress закрыть от индексации сайт через админку. В настройках (раздел чтение), есть удобная функция:

Можно убрать видимость сайта, но обратите внимание на подсказку. В ней говорится, что поисковые системы всё же могут индексировать ресурс, поэтому лучше воспользоваться проверенным способом и добавить нужный код в robots.txt

Текстовый файл robots находится в корне сайта, а если его там нет, создайте его через блокнот.

Закрыть сайт от индексации поможет следующий код:

User-agent: *

Disallow: /

Просто добавьте его на первую строчку (замените уже имеющиеся строчки). Если нужно закрыть сайт только от Яндекса, вместо звездочки указывайте Yandex, если закрываете ресурс от Google, вставляйте Googlebot.

Когда проделаете эти действия, сайт больше не будет индексироваться, это самый лучший способ для закрытия ресурса от поисковых роботов.

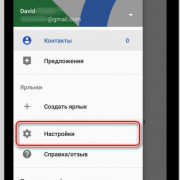

Установка плагина WP Maintenance Mode

Данный плагин очень прост в настройке, имеет много различных возможностей и не нагружает ваш сайт.

Вы можете его активировать только тогда, когда он вам нужен, а если вы не используете данный плагин, то вы его просто деактивируете и он вообще не дает ни какой нагрузки на сайт.

- 1.Копируем его название и переходим в админку сайта.

- 2.Устанавливаем и активируем его как любой другой плагин.

- 3.И после его установки у вас в разделе «Настройки» появится пункт «Техническое обслуживание». Переходим в этот раздел, и мы видим, что все настройки данного плагина разбиты на несколько вкладок.

-

4.Прежде всего, что бы включить режим техобслуживания и закрыть ваш сайт для посетителей необходимо выставить здесь «Включено»

- 5.На этой же вкладке вы можете выбрать закрывать ли ваш сайт от индексации

-

6.Так же вы можете выбрать, пользователи с какими правами, а точнее ролями, могут иметь доступ к административной части вашего сайта.

Когда вы создаете нового пользователя или редактируете уже существующего, WordPress позволяет назначать этому пользователю определенную роль. Это может быть подписчик, участник, автор, редактор и администратор.

Так вот, в настройках данного плагина вы можете задать определенные группы пользователей с определенными ролями для доступа к панели управления сайтом и к фронт-энду сайта.

Если вам нужно просто временно закрыть ваш сайт для внесения определенных правок, то выставлять здесь ни чего не нужно.

Так же, здесь можно выставить мета тэг для роботов, но, опять таки, если вы кратковременно закрываете сайт, то все эти настройки вам не понадобятся.

Ещё у данного плагина есть возможность перенаправлять всех посетителей, зашедших по адресу вашего сайта на какую-то определенную страницу, или на какой-то другой сайт.

Здесь же можно добавить определенные исключения, то есть, что бы у посетителя был доступ к новостной ленте, архивам сайта, страницам, и так далее.

7.После того, как вы включаете режим технического обслуживания у вас, в административной части сайта, при редактировании каких-то страниц и установке плагинов, постоянно высвечивается предупреждение о том, что у вас включен режим технического обслуживания.

Это делается для того, что бы вы ни забыли его отключить после того, как внесете все необходимые правки. На вкладке «Общие» вы можете выбрать, высвечивать это предупреждение, или нет. Я рекомендую вам оставить здесь «Да».

8.Так же, при желании, на странице технического обслуживания вы можете добавить, либо не добавлять, ссылку для входа в панель управления.

9.После того, как все настройки заданы нажимаем на кнопку «Сохранить настройки».

Если я сейчас из админки перейду на страницу данного сайта, то для меня как для администратора, данный сайт будет, по-прежнему, доступен. Однако, если я, например, выйду из административной части сайта, или зайду на сайт через другой браузер, то я увижу вот такую картину:

Текст данного сообщения вы так же можете менять в настройках плагина.

Использование спецсимволов в командах robots.txt

В командах robots.txt может использоваться два спецсимвола: * и $:

- Звездочка * заменяет собой любую последовательность символов.

- По умолчанию в конце каждой команды добавляется *. Чтобы отменить это, в конце строки необходимо поставить символ $.

Допустим, у нас имеется сайт с адресом site.com, и мы хотим настроить файл robots.txt для нашего проекта. Разберем действие спецсимволов на примерах:

| Команда | Что обозначает |

| Disallow: /basket/ | Запрещает индексацию всех документов в разделе /basket/, например:site.com/basket/ site.com/basket/2/ site.com/basket/3/ site.com/basket/4/ |

| Disallow: /basket/$ | Запрещает индексацию только документа: site.com/basket/Документы: site.com/basket/2/ site.com/basket/3/ site.com/basket/4/остаются открытыми для индексации. |

Блокировка индексации сайта robots.txt

К данному ресурсу обращаются чаще всего на

стадии разработки сайта, когда вмешательство поисковых систем крайне

нежелательно. Далее представлена подробная инструкция, как блокировать

индексацию сайта при помощи robots.txt:

- в корне сайта необходимо создать текстовый файл robots.txt и прописать в нем строки, позволяющие скрыть все ссылки от любого поискового бота (защита предназначена для всех видов браузеров);

- форма записи для проведения операции скрытия информации: «Users-agens:*\ Disallow»;

- в последнем разделе после двоеточия вы указываете тип скрываемой информации: папка, отдельный файл в Яндекс, картинку или второй домен.

Для каждой поисковой системы задано свое имя,

к которому вы обращаетесь, вводя его наименование в разделе Disallow.

Зачем закрывать ссылки от индексации

Одну причину скрытия внешних ссылок мы уже

рассмотрели ранее. Однако, на практике можно столкнуться и еще с одной задачей

защиты контента. Наличие ссылок на внешние ресурсы значительно увеличивает вес html-страницы за счет дополнительного контента стороннего сайта, а это означает

низкую скорость загрузки и медленную работу веб ресурса. Принцип защиты от индексации заключается в сокрытии

истинного веса html-страницы различными путями (запрет перехода по

ссылкам, отведение информации на отдельные файлы).

Зачем это нужно

Для начала расскажу, почему следует закрывать ссылки, ведущие на другие сайты, от индексации. Если у вас молодой сайт с низкой посещаемостью – эта информация особенно важна.

Итак, основные причины, по которым веб-мастерам необходимо это знать, вот в чем:

- Каждая ссылка, ведущая на чужой сайт и не закрытая через атрибут «nofollow», передаёт вес вашей страницы.

- Используя этот атрибут, опытный веб-мастер может грамотно распределить вес страниц на своём сайте, чтобы выбиться в топ по определенным запросам.

- Возможность закрыть от поисковиков ненужные или низкоприоритетные страницы.

Каждая из причин влияет на продвижение в поисковой выдаче. При грамотном подходе, вполне можно улучшить позиции сайта и суметь выбиться в топ по достаточно конкурентным запросам, даже если ваш ресурс еще молод.

Внутренние ссылки

Внутренние ссылки закрываются от индексации для перераспределения внутренних весов на основные продвигаемые страницы. Но дело в том, что:

– такое перераспределение может плохо отразиться на общих связях между страницами;

– ссылки из шаблонных сквозных блоков обычно имеют меньший вес или могут вообще не учитываться.

Рассмотрим варианты, которые используются для скрытия ссылок:

Для скрытия ссылок этот тег бесполезен. Он распространяется только на текст.

Атрибут rel=”nofollow”

Сейчас атрибут не позволяет сохранять вес на странице. При использовании rel=”nofollow” вес просто теряется. Само по себе использование тега для внутренних ссылок выглядит не особо логично.

Представители Google рекомендуют отказаться от такой практики.

Рекомендацию Рэнда Фишкина:

Скрытие ссылок с помощью скриптов

Это фактически единственный рабочий метод, с помощью которого можно спрятать ссылки от поисковых систем. Можно использовать Аjax и подгружать блоки ссылок уже после загрузки страницы или добавлять ссылки, подменяя скриптом тег на

При этом важно учитывать, что поисковые алгоритмы умеют распознавать скрипты

Как и в случае с контентом – это «костыль», который иногда может решить проблему. Если вы не уверены, что получите положительный эффект от спрятанного блока ссылок, лучше такие методы не использовать.

Ошибки, связанные с файлом robots.txt

Одна из самых распространенных ошибок – перевернутый синтаксис.

Неправильно:

User-agent: /

Disallow: Yandex

Правильно:

User-agent: Yandex

Disallow: /

Неправильно:

User-agent: *

Disallow: /dir/ /cgi-bin/ /forum/

Правильно:

User-agent: *

Disallow: /dir/

Disallow: /cgi-bin/

Disallow: /forum/

Если при обработке ошибки 404 (документ не найден), веб-сервер выдает специальную страницу, и при этом файл robots.txt отсутствует, то возможна ситуация, когда поисковому роботу при запросе файла robots.txt выдается та самая специальная страница, никак не являющаяся файлом управления индексирования.

Ошибка, связанная с неправильным использованием регистра в файле robots.txt. Например, если необходимо закрыть директорию «cgi-bin», то в записе «Disallow» нельзя писать название директории в верхнем регистре «cgi-bin».

Неправильно:

User-agent: *

Disallow: /CGI-BIN/

Правильно:

User-agent: *

Disallow: /cgi-bin/

Ошибка, связанная с отсутствием открывающей наклонной черты при закрытии директории от индексирования.

Неправильно:

User-agent: *

Disallow: dir

User-agent: *

Disallow: page.HTML

Правильно:

User-agent: *

Disallow: /dir

User-agent: *

Disallow: /page.HTML

Чтобы избежать наиболее распространенных ошибок, файл robots.txt можно проверить средствами Яндекс.Вебмастера или Инструментами для вебмастеров Google. Проверка осуществляется после загрузки файла.

Пример настройки файла robots.txt

Давайте разберем на примере, как настроить файл robots.txt. Ниже находится пример файла, значение команд из которого будет подробно рассмотрено в статье.

В данном файле мы видим, что от поисковых систем Яндекс и Google закрыты от индексации все документы на сайте, кроме страницы /test.html

Остальные поисковые системы могут индексировать все документы, кроме:

- документов в разделах /personal/ и /help/

- документа по адресу /index.html

- документов, адреса которых включают параметр clear_cache=Y

Последние две команды требуют отдельного внимания.

Командой /index.html закрыт от индексации дубль главной страницы сайта. Как правило, главная страница доступна по двум адресам:

- site.com

- site.com/index.html или site.com/index.php

Если не закрыть второй адрес от индексации, то в поиске может появиться две главных страницы!

Команда Disallow: /*?clear_cache=Y закрывает от индексации все страницы, в адресах которых используется последовательность символов ?clear_cache=Y. Часто различный функционал на сайте, например, сортировки или формы подбора добавляют к адресам страниц различные параметры, из-за чего генерируется множество страниц-дублей. Закрывая дубли с параметрами от индексации, Вы решаете проблему попадания дублей в базу поисковых систем.

Посмотрите, какие страницы необходимо закрывать от индексации, в статье про проведение технического аудита сайта.

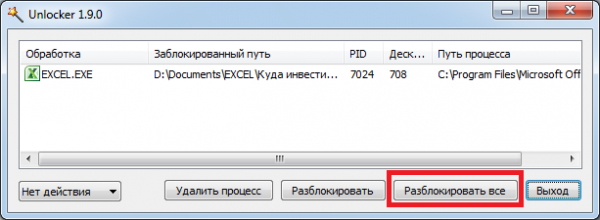

Как заблокировать сайт в файле hosts, чтобы он не открывался

Наиболее простым и верным вариантом, для того чтобы прикрыть доступ к одному или сразу нескольким адресам, является решение с изменениями в так называемом файле hosts. Данный объект принадлежит Windows, но открыть его можно обычным Блокнотом. Он позволяет прописывать сайты, чтобы они больше не открывались. Для этого потребуется добавлять отдельной строчкой IP своего ПК и далее вписывать наименования ресурсов. Помимо этого, хостс перенаправит пользователя на другой сайт при попытке нарушения запрета. Инструкция будет следующей:

Находите нужный системный файл по пути:

C | Window | System32 | drivers | etc

- Для его открытия необходимо нажать правую кнопку мышки. После этого будет доступно дополнительное меню с командой «Открыть с помощью…»;

- Используете простой «Блокнот».

Теперь без смены ай-пи вписываете адреса для блокировки, каждый с новой строки. После этого сохраняете изменения.

После можете протестировать свои усилия, открыть любую программу и проверить один из вписанных сайтов.

Этот способ поможет заблокировать неограниченное количество сайтов, но о нем знают лишь «продвинутые» юзеры. Вот только изменить что-то в файле hosts можно только, если открывали его в режиме администратора.

Это может пригодиться:

- Как исправить ошибку sec error revoked certificate в Firefox

- Устраняем ошибку 14098 — хранилище компонентов повреждено

- Устраняем ошибку «Системе не удается найти указанный путь» при скачивании торрентов

- Как освободить память Android, ничего не удаляя!

- Как на Айфоне почистить кэш, освободить память

Что такое индексация

Индексация – это процесс, который подразумевает считывание всей информации вашего ресурса для дальнейшего занесения ее в базы ПС. Иными словами, это когда поисковики анализируют ваш сайт, чтобы потом выдавать его пользователям в поисковой выдаче. В процессе индексации учитывается абсолютно все: начиная от дизайна и заканчивая количеством текста в статьях.

В процессе индексации сайта ПС могут делать для себя определенные пометки. Например, если вы начнете размещать на своем веб-ресурсе копипаст, то ваш сайт может попасть под фильтр. В таком случае он больше не будет участвовать в поисковом ранжировании на равных условиях с другими проектами. Поисковик будет просто занижать ресурс в позициях либо вовсе уберет его из результатов.

То же касается и каких-то других аспектов SEO-продвижения. Во время индексации поисковые роботы анализируют все показатели, чтобы определить качество сайта и возможность размещения страниц по каким-то определенным запросам. Если на проекте отсутствует информация (статьи и страницы), то разместить его где-то либо не представляется возможным.

Такой веб-ресурс будет доступен только по прямому обращению с использованием специальных регулярных выражений. В общих результатах его не встретить.

Роботы ПС начинают индексацию всех открытых сайтов сразу же после их создания. Вы даже можете не добавлять свой проект в Яндекс.Вебмастер и Google Search Console, но роботы все равно придут на ваш ресурс и начнут аудит всей доступной информации. Если вы только что создали свой проект, естественно, вам подобная индексация не нужна. Например, очень часто при создании проектов люди пользуются шаблонами.

Чтобы лучше настроить внешний вид ресурса, они загружают специальные демо-конфигурации, которые в автоматическом режиме создают тестовые варианты статей. Это, как правило, копипастные материалы, которые нужны только для того, чтобы тема оформления выглядела должным образом. Согласитесь, настраивать шаблон намного проще, если ты сразу видишь, как это все будет выглядеть в конечном итоге. Когда ресурс пустой, настроить шаблон должным образом бывает очень сложно.

Это особенно актуально для проектов на WordPress, потому как тема на заполненном проекте и тема на пустом выглядят совершенно по-разному. Пользователи выгружают демо-контент, чтобы настроить внешний вид, и в случае, если проект не был закрыт от ПС, эти самые страницы с демо-контентом могут попасть в поисковую выдачу.

Естественно, они будут на самых последних страницах, но тем не менее это будет создавать негативный эффект для SEO-продвижения. По сути, это можно рассматривать как попадание мусорных страниц и документов в ПС. Потом вам придется удалять их все, на что может потребоваться определенное время.

Видимого негативного эффекта от этого, конечно, быть не должно. Однако некоторые трудности возникнут. Ваш веб-ресурс не будет классифицироваться как полностью уникальный, и в некоторых случаях поисковые роботы будут занижать позиции уже настоящих статей в выдаче. Даже после удаления всех этих демо-материалов эффект может держаться еще какое-то время.

Именно поэтому при начальной разработке проекта лучше закрыть его от индексации и открывать уже только после того, как он будет полностью готов. Причем это касается не только демо-контента, но и, вообще, любой разработки – дизайна, скорости загрузки и т. д. Если что-то на ресурсе не работает должным образом, лучше это на время скрыть от глаз пользователей и ПС.

Помимо закрытия на этапе разработки, есть и другие причины для того, чтобы исключить свой проект из поисковой выдачи. К примеру, это может понадобиться специализированным ресурсам, материалы которых не должны быть в общем доступе. Обычно это какие-то специальные закрытые проекты, информация на которых предназначена для ограниченного количества людей.

Естественно, если поисковые системы начнут считывать информацию с таких проектов, то ни о какой приватности речь идти не будет. Все данные будут доступны для изучения с помощью различных сервисов. Сами ПС сохраняют слепки сайтов, поэтому, даже если владельцы проекта решат удалить информацию, которая по ошибке попала в поисковик, где-то может остаться сохраненная копия.

Также закрытие проекта от индексации актуально для внутренних ресурсов различных компаний, которые создают такие сайты для своих сотрудников. Это могут быть специальные панели управления, страницы с расписанием и т. д.

В общем, причин для закрытия проекта от поисковых систем очень много. Да и способов реализации этого тоже.

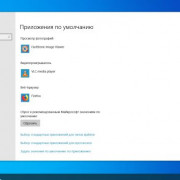

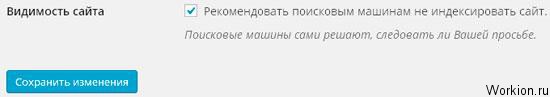

Как закрыть сайт от индексации в WordPress?

Данный способ, наверное, самый простой, и владельцам сайтов, которые созданы на базе CMS WordPress, очень повезло. Дело в том, что в данной CMS предусмотрена возможность закрытия сайта от индексации при установке движка на хостинг. В случае если вы не сделали этого при установке, вы всегда можете это сделать в настройках. Для этого вам нужно:

- 1.В админпанели переходим в раздел «Настройки» → «Чтение».

-

2.Перелистываем открывшуюся страницу в самый низ, и отмечаем галочкой опцию показанную на скриншоте:

- 3.Сохраняем изменения.

Все. Теперь ваш сайт не будет индексироваться. Если открыть страницу в браузере и нажать комбинацию клавиш CTRL+U, мы сможем просмотреть код страницы, и увидим вот такую строку кода:

Данная запись была добавлена автоматически, после того как мы включили опцию запрета индексации в настройках.

Главное не забыть отключить эту опцию после завершения работ:)